O escritor britânico J. G. Ballard escreveu uma vez que “tudo está virando ficção científica”.

O imaginário a respeito da tecnologia, a respeito de seus superpoderes, é o resultado do pensamento de décadas. De gerações. Da mobilização de gente da engenharia, economia, filosofia, literatura, comunicação, sociologia.

Já no início do século XIX, em 1818, o Frankenstein de Mary Shelley especulava sobre a capacidade humana de replicar os fenômenos da natureza — e, nisso, buscar caminhos para compreender a condição humana. A vontade de replicar a vida é também, afinal, uma profunda curiosidade sobre seu funcionamento.

No Monstro de Frankenstein, Shelley nos apresenta uma questão que irá se repetir nos séculos que virão pela frente. Seu Monstro se apresentará, ao longo de sua história, igualmente bruto e reflexivo; a ideia de uma vida, e uma inteligência artificiais, fruto das mãos humanas, trará nas páginas de Shelley reflexões sobre a metafísica, os arranjos sociais, sobre a própria ciência. É não tão lembrado, afinal, o adendo ao título do livro de Shelley: Frankenstein, ou O Prometeu Moderno.

Num tempo anterior ao freudianismo, a literatura se encarregava dessa investigação sobre as zonas cinzentas a conformar novos indivíduos em um novo mundo. Essa percepção a imbricar ciência, tecnologia, e vida interior — inteligência — transbordará da filosofia e se mostrará, então, tema recorrente na arte. E saltará, a partir daí, ao imaginário público.

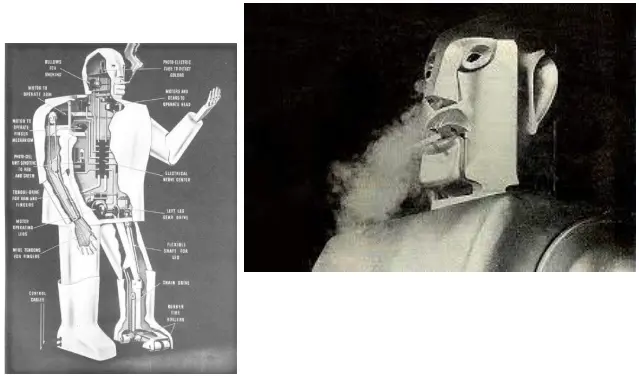

Na Feira Mundial de Nova Iorque, em 1939, uma das atrações era Elektro, o Moto-Man. Criado pela Westinghouse Electric Corporation, Elektro mostrava um outro tipo de inteligência artificial. O que viemos a entender como robô. A inteligência artificial, ali, propunha uma replicação do trabalhador urbano integrado ao maquinário capitalista, senhor daquele novo tipo de vida. Cigarrinho na boca e tudo.

Ali já dava para perceber uma aproximação entre a ideia de inteligência artificial e o desenvolvimento tecnoindustrial. Elektro não era movido a computadores ainda, mas a força libertadora da indústria, da tecnologia e da ciência, certamente lhe daria vida.

De certo modo, foi mais ou menos o que aconteceu.

Nos anos 1940 e 1950, no rescaldo da Segunda Guerra, uma aliança entre governo, academia e indústria nos EUA e Europa reestruturou os atores e espaços de produção tecnológica. E da convergência entre cálculo e engenharia, entre sistemas eletrônicos e infraestrutura comunicacional, nasceu a informática.

Nesse universo produtivo estruturado sobre novos arranjos, o processamento de transações econômicas, a distribuição de produtos, a complexidade dos desafios logísticos da indústria e dos setores financeiro e de serviços encontrou, em soluções informáticas originalmente desenvolvidas como estratégia de defesa na Guerra Fria, ferramentas que automatizavam processos de gestão, reformulando hierarquias e fluxogramas.

Nas décadas seguintes à Segunda Guerra Mundial, novas redes de comunicação aceleraram o tempo das transações comerciais, num movimento que trouxe, também, a necessidade de novas técnicas e aparatos para o processamento e distribuição de produtos e serviços: a expansão da energia elétrica criou mercados e espaços de consumo para novos produtos eletrônicos; a construção de estradas e o desenvolvimento de novas tecnologias de transporte se capilarizou em uma rede viária cada vez mais interligada.

Surgia, ali, um novo cenário. Interconectado. O setor produtivo privado responderá com a criação de novas estruturas e tecnologias gerenciais, estabelecendo espaços de trabalho não apenas assistidos, mas totalmente efetuados pela nova e emergente tecnologia de processamento de dados — afinal, algumas tarefas de tabulação e acompanhamento sistemático que anteriormente seriam feitos por humanos podiam, agora, ser repassados às máquinas. Surgia uma nova burocracia corporativa gerenciada numa hierarquia híbrida, em que o humano, e também a máquina, desempenhavam papeis de organização e processamento. O setor produtivo e a vida econômica e social eram reestruturados numa nova burocracia.

***

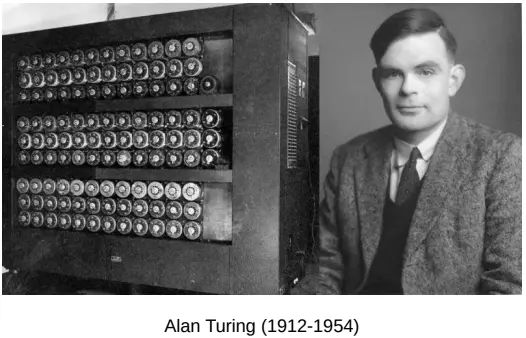

A noção de inteligência artificial é, inevitavelmente, associada ao matemático britânico Alan Turing. Envolvido desde meados dos anos 1930 na pesquisa de sistemas automatizados de processamento informacional (em 1936 ele havia publicado paper no qual propunha um modelo abstrato para um computador programável, o qual batizou de “máquina universal”), Turing viu, no ambiente de pesquisa empreendido pelo governo britânico em seu confronto contra os nazistas, o laboratório no qual poderia levar a cabo algumas de suas ideias, entrelaçando suas propostas de inteligência artificial ao desenvolvimento da tecnologia criptográfica a ser usada na decodificação de dados inimigos durante a guerra.

Tendo encontrado na iniciativa de guerra britânica a incubadora para o desenvolvimento e aplicação de seu modelo de computação (a “máquina universal”), Turing convenceu o governo a encaminhar experiências para além dos tabuladores analógicos, adentrando o cálculo eletrônico. Acabada a guerra, dedicou-se à realização de seu projeto desenvolvendo, em 1948, o primeiro computador eletrônico armazenador de programas do mundo: o Baby.

Para Turing, sua criação era mais do que uma simples máquina de processamento de dados. Tendo levado a cabo um sistema de organização da informação baseado em sua ideia de inteligência artificial, que dialogava com elementos do que considerava a estrutura essencial do raciocínio humano, o matemático britânico defendeu em papers que o Baby “era a precursora de uma nova forma de vida completa: o matemático mecânico. Quando os programas controlassem os equipamentos, o ato de contar se tornaria “consciência”.

***

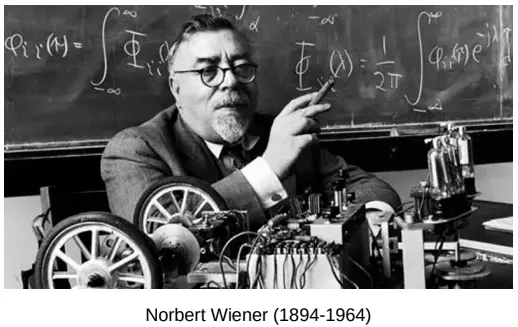

Na Segunda Guerra Mundial, o matemático estadunidense Norbert Wiener desenvolveu, patrocinado pelo exército dos Estados Unidos, estudos sobre interação homem-máquina que otimizassem resultados de artilharia em campos de batalha. Em sua pesquisa, Wiener propôs uma técnica que, partindo de dados levantados a partir da previsão, pelo atirador, do ponto futuro no qual um alvo em movimento se encontraria no momento de receber o disparo, sua pontaria fosse automaticamente corrigida pelo seu equipamento.

O objetivo de Wiener era otimizar a relação entre soldados e seu armamento, calculando a partir do comportamento da arma em relação ao manuseio de atirador, das forças físicas a ela aplicadas, e do comportamento móvel do alvo a ser atingido, uma dinâmica de funcionamento a partir da qual a resposta mecânica do soldado ao armamento, e do armamento ao soldado, viabilizassem a otimização da ação a ser efetuada. Sua premissa partia da noção segundo a qual “a entrada de informação sobre o ambiente ao redor resultava em ações destinadas à transformação desse ambiente.”

Com o nome “feedback” (ou “retroalimentação”), o conceito se tornou motor da cibernética, uma nova estrutura teórica desenvolvida por Norbert Wiener para analisar o comportamento de humanos e máquinas. Emprestando noções da biologia, das ciências sociais aplicadas e das ciências exatas, a cibernética desenha uma estrutura teórica que abre novas interfaces entre campos distintos do saber e da pesquisa acadêmica, botando abaixo compartimentações e desenhando novas possibilidades para os estudos interdisciplinares. Em sua proposta, Norbert Wiener circunscreve um campo comum à engenharia e às ciências biológicas na terminologia e no estudo das relações entre máquinas e seres vivos.

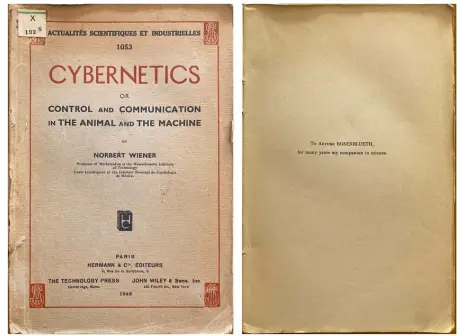

Essa teoria é, em 1948, esboçada por Wiener em seu livro “Cibernética – Ou o comando e a comunicação no animal e na máquina” — obra que, entremeando discussão conceitual e matemática aplicada, é abraçada pelo público para além do círculo acadêmico, tornando-se um sucesso de vendas e influenciando não apenas a produção científica, mas o próprio imaginário coletivo e a produção cultural de massa.

A aproximação programática entre o projeto de Alan Turing e a cibernética se dá com outro pesquisador envolvido nos grupos de pesquisa interdisciplinar herdeiros dos coletivos científicos da Segunda Guerra Mundial: John von Neumann.

Contraponto ideológico a Wiener, von Neumann, matemático húngaro de viés liberal (traumatizado pela nacionalização do banco de sua família na Revolução Húngara de 1919, abraçou o ideário antissocialista), este pioneiro da Teoria dos Jogos utilizou-se de ferramentas ancoradas no liberalismo ortodoxo para a criação de sistemas de processamento e organização da informação, trabalhando em conjunto com as forças armadas dos EUA e em consonância com o programa militarizado da Guerra Fria. Não surpreende, portanto, que Wiener e von Neumann tenham vindo a defender interpretações rivais da cibernética, com o segundo aproximando-se das ideias de Turing, com quem trabalhou brevemente na Universidade de Princeton. Von Neumann, assim como Turing, acreditava que o contínuo aperfeiçoamento da tecnologia computacional desaguaria na emergência da inteligência artificial. Envolvido com o desenvolvimento de computadores desde a década de 1940 (em 1946 já trabalhava com seu time de pesquisadores na criação de tecnologia de mainframes para as forças armadas dos EUA), e ideologicamente consonante com o pensamento estadunidense da Guerra Fria, na década de 1950, a interpretação cibernética de von Neumann ganharia a dianteira no campo científico ocidental, tornando-o o principal nome no assunto.

As ideias de Alan Turing influenciaram toda a pesquisa computacional consecutiva. Apesar do entrelaçamento de seus projetos com a cibernética, a computação e a inteligência artificial, Norbert Wiener divergia de Turing e sua proposta de um futuro habitado por máquinas conscientes. Para Wiener, as inteligências artificiais, se levadas à última consequência e materializadas num futuro habitado por máquinas dotadas de raciocínio lógico e consciência, poderiam se revelar um risco à tarefa de criar justiça social e paz global — agenda que, para ele, seria possível apenas com um claro projeto orientado pelo controle humano em sua interação com seus novos artefatos tecnológicos.

No início da década de 1950, von Neumann havia criado com sucesso a cibernética sem Wiener. A metáfora da retroalimentação, agora, provava que os computadores operavam como humanos. Como os jogadores racionais de seus livros sobre a teoria dos jogos, ambos, seres vivos e mecânicos, respondiam a estímulos do ambiente à sua volta. Entradas de informação dirigiam-se às saídas de ação. Desde que o comportamento de ambos, humanos e máquinas, puderam ser descritos matematicamente, cálculos se tornaram o fio condutor da consciência.

***

Num ensaio de 1980, o pensador da tecnologia Langdon Winner propôs uma questão: Artefatos têm Política?

Numa reflexão sobre a altura das pontes, o tamanho das praças, o circuito das avenidas, Winner apontará que a aplicação prática da tecnologia de engenharia civil, e suas adaptações de uso, não deixam de trazer em si as relações de força e poder da cidade.

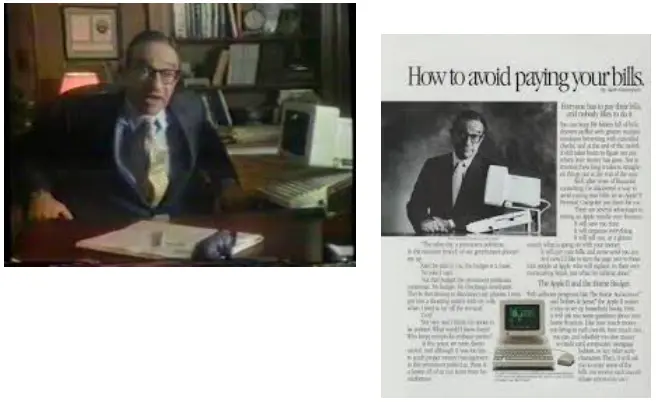

Winner buscava, em sua análise, apontar aos programas políticos e econômicos que entrelaçavam a tecnologia computacional às novas esferas da vida social. A alquimia que transformava mainframes em computadores pessoais mudava, também, o próprio sentido de uso dos computadores. E, junto, o imaginário público a seu respeito.

Assim como o computador entendido como mainframe era uma resposta e uma solução às mudanças produtivas e sociais dos EUA da metade do século XX, o computador pessoal saído do caldeirão dos anos 1960 e 1970 trazia, também, uma solução às mudanças econômicas das últimas décadas do século.

Não à toa, em 1985, Alan Greenspan, economista liberal, do círculo de Ayn Rand foi garoto propaganda nos comerciais que, na TV, apresentavam o Apple II. Um dos primeiros artefatos a popularizar a ideia de computador pessoal.

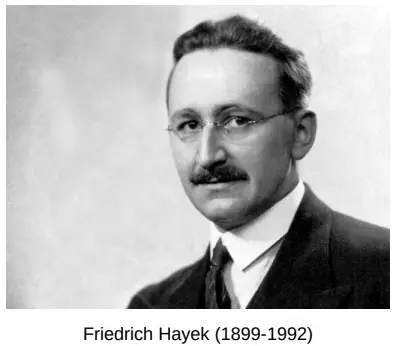

Em 1945, Friedrich Hayek publicou um artigo chamado “O uso do conhecimento na sociedade”. Sua proposição era a seguinte: como, num tempo anterior à computação ubíqua, o sistema de preços se regularia? Para Hayek, o que existia ali era um grande, gigantesco processador de dados. A sociedade seria, afinal, como um grande computador.

Um gigantesco computador que, afinal, parece se encaixar perfeitamente à noção de Inteligência Artificial de Turing e de von Neumann; e que, hoje, parece, como o Monstro de Frankenstein, encantar o imaginário das pessoas no que seria uma espécie de nova encarnação, a IA generativa encontrada em plataformas como o ChatGPT.

Hayek foi o principal teórico e ideólogo do que veio a ser entendido como Neoliberalismo. E a ideia de uma sociedade a funcionar como um processador de informação contínua se cristalizou na economia imaterial da Internet e na crença quase metafísica em um certo “equilíbrio natural do mercado”.

Assim como os mainframes eram a resposta às necessidades de uma nova economia industrial, a expansão computacional, e a automatização de seus processos, parece, também, ser uma resposta às transformações trazidas pela financeirização e pela expansão do neoliberalismo.

No mesmo ensaio que abre o texto, escrito em 1971, J. G. Ballard aponta que “o futuro é um caminho para desvendar mais o presente do que o passado”*.

Resta saber o que ainda restaria de futuro num mundo de tanto agora.

Esse texto é a versão editada da apresentação feita pelo autor no XV Congresso de História Econômica da Universidade de São Paulo e também foi publicado na revista Jacobina.

*Os trechos citados são parte do ensaio “Fictions of Every Kind”, ensaio de J. G. Ballard publicado em 1971.